Сотрудники факультета представят свои работы на конференциях по машинному обучению ICLR и AISTATS

С 16 по 18 апреля 2019 года в Ноха, Япония пройдет 22-ая международная конференция International Conference on Artificial Intelligence and Statistics (AISTATS), имеющая ранг A по рейтингу CORE.

В этом году на основном треке AISTATS с докладом Doubly Semi-Implicit Variational Inference выступят исследователи группы байесовских методов: Дмитрий Молчанов, Валерий Харитонов, Артем Соболев и Дмитрий Ветров. В работе было предложено расширение подхода вариационного вывода на случай вероятностных моделей с полунеявным априорным распределением.

Также с 6 по 9 мая 2019 года в Новом Орлеане, США пройдет 7-ая международная конференция International Conference on Learning Representations (ICLR) — одна из самых быстрорастущих конференций, посвященных глубинному обучению. В этом году на конференцию была подана 1591 работа, из которых 524 были приняты.

В этом году на основном треке конференции ICLR будет представлено три работы сотрудников факультета:

- Variance Networks: When Expectation Does Not Meet Your Expectations (авторы: Кирилл Неклюдов, Дмитрий Молчанов, Арсений Ашуха, Дмитрий Ветров)

- Variational Autoencoder with Arbitrary Conditioning (авторы: Олег Иванов, Михаил Фигурнов, Дмитрий Ветров)

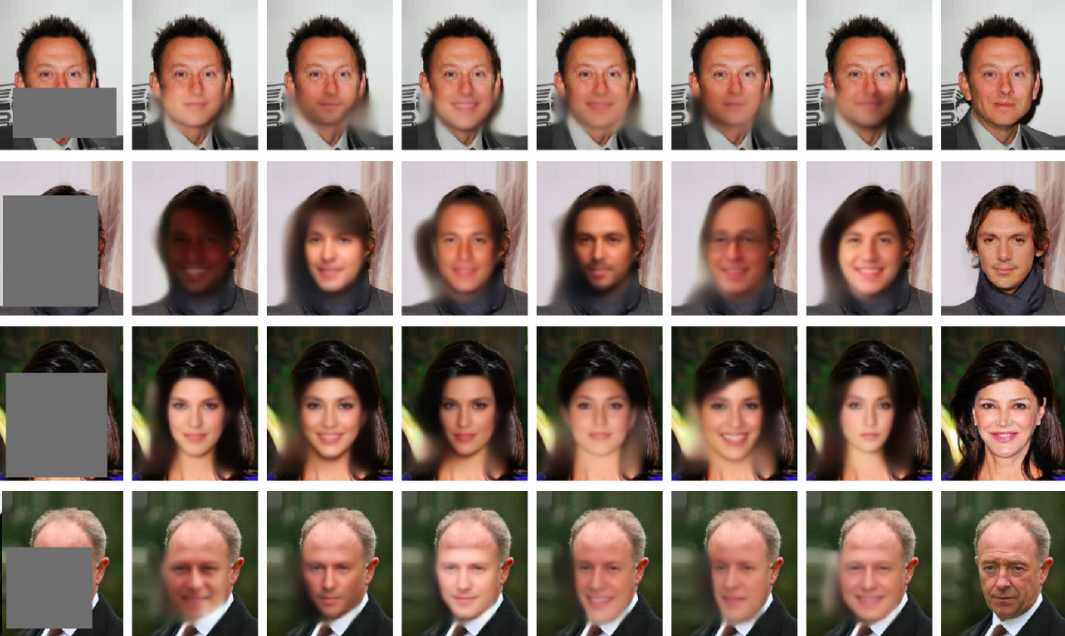

- The Deep Weight Prior (авторы: Андрей Атанов, Арсений Ашуха, Кирилл Струминский, Дмитрий Ветров, Макс Веллинг)

Кирилл Неклюдов

Аспирант ФКН, научный сотрудник Лаборатории компании Самсунг

“

В работе Variance Networks: When Expectation Does Not Meet Your Expectations нами был обнаружен крайне занимательный эффект: если выставить среднее значение весов байесовской нейронной сети в 0 и обучать только дисперсии можно добится state-of-the-art качества на тестовой выборке. Данное наблюдение может говорить о том, что большое количество шума не только не мешает работе нейронных сетей но и может хранить всю необходимую информацию в дисперсиях.

.jpg)

Дмитрий Ветров

Профессор-исследователь ФКН

“

Две работы “The Deep Weight Prior” и “Doubly Semi-Implicit Variational Inference” посвящены использованию полунеявных генеративных моделей, в которых распределение моделируется в неявной форме, т.е. без аналитического доступа к плотности. Такой подход позволяет моделировать сложные распределения в пространствах большой размерности, например в пространстве весов нейронных сетей. Исследование проводится совместно с научной группой Макса Веллинга — крупнейшего мирового специалиста в вероятностном машинном обучении.