Две статьи приняты на конференцию NAACL 2021

Статьи Надежды Чирковой и Сергея Трошина приняты в программу конференции NAACL, одной из ведущих по тематике обработки естественного языка.

Две статьи сотрудников центра приняты на одну из ведущих мировых конференций по обработке естественного языка, Annual Conference of the North American Chapter of the Association for Computational Linguistics (NAACL 2021)

-

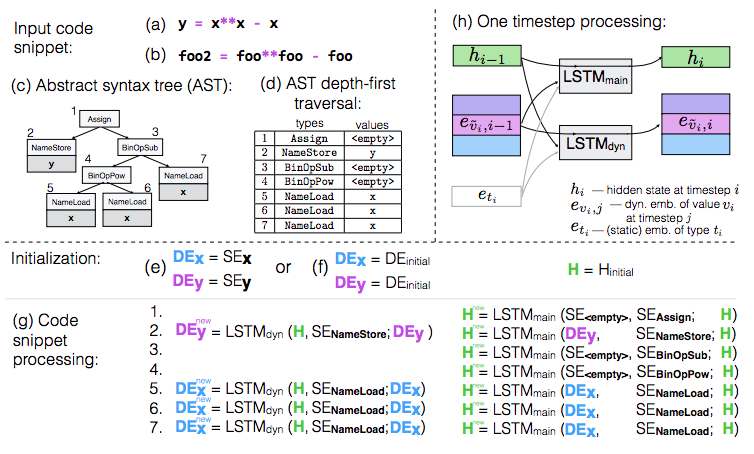

“On the Embeddings of Variables in Recurrent Neural Networks for Source Code” (автор: Надежда Чиркова);

-

“A Simple Approach for Handling Out-of-Vocabulary Identifiers in Deep Learning for Source Code” (авторы: Надежда Чиркова и Сергей Трошин).

Финальные версии статей и сопровождающий код будут доступны в ближайшее время. Исследование выполнено с использованием вычислительных ресурсов Суперкомпьютерного комплекса НИУ ВШЭ.

Обе статьи решают задачу совершенствования нейросетевых моделей, анализирующих исходный код программ, с помощью учета специфики имен переменных. В первой статье предлагается рекуррентная архитектура, в явном виде моделирующая роль переменных в программе. Во второй статье предлагается простой метод предобработки редко используемых переменных, позволяющий нейросетям (в частности, архитектуре Трансформер) более качественно анализировать программу. Оба метода значительно повышают качество нейросетевого автодополнения кода и автоматического обнаружения неправильно использованной переменной.