О Центре

Центр ведет исследования на стыке двух активно развивающихcя сегодня областей анализа данных: глубинного обучения и байесовских методов машинного обучения. Глубинное обучение - это раздел, подразумевающий построение очень сложных моделей (нейронных сетей) для решения таких задач, как классификация изображений или музыки, перенос художественного стиля с картины на фотографию, предсказание следующих слов в тексте. В рамках байесовского подхода для решения подобных задач рассматриваются вероятностные модели, опирающиеся на аппарат теории вероятностей и математической статистики.

Центр создан на основе исследовательской группы байесовских методов машинного обучения Д.П. Ветрова.

Трое сотрудников Центра глубинного обучения и байесовских методов награждены стипендией Яндекса

Сразу трое сотрудников Центра глубинного обучения и байесовских методов стали лауреатами стипендии Яндекса в 2025 г.

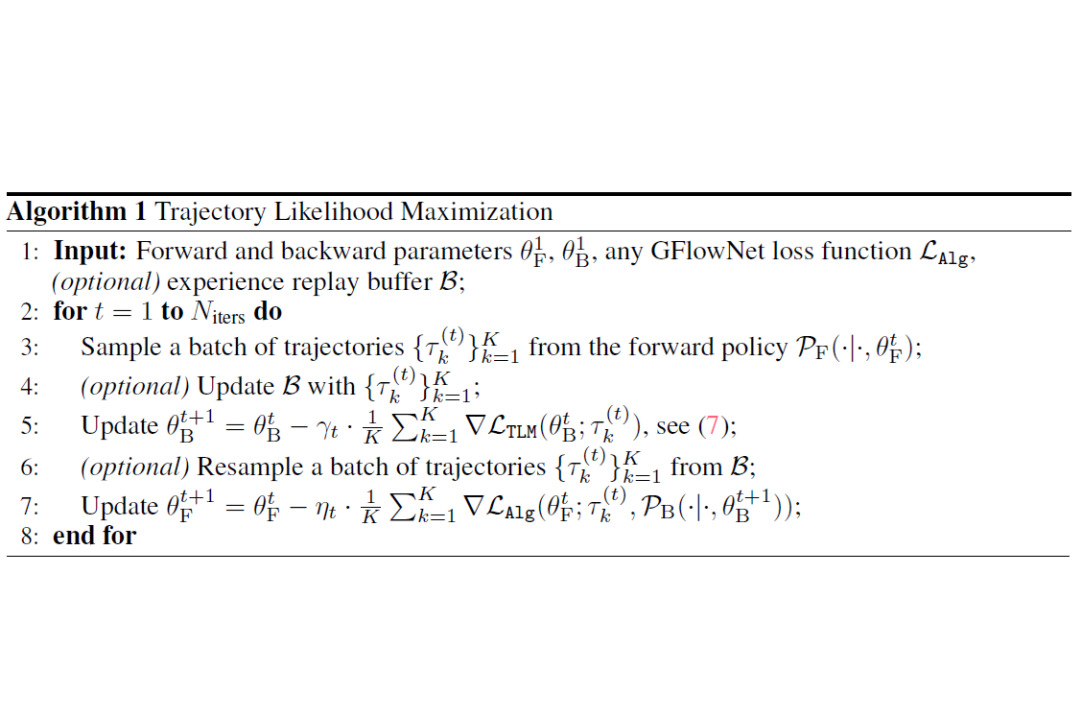

Статья сотрудников Bayes Lab и HDI Lab принята на конференцию ICLR-2025

Статья Тимофея Грицаева и Никиты Морозова, написанная в соавторстве с сотрудниками HDI Lab Сергеем Самсоновым и Даниилом Тяпкиным, принята в программу конференции ICLR, одной из ведущих в области машинного обучения и искусственного интеллекта.