В НУЛ компании Яндекс прошел семинар "Квантизация больших языковых моделей"

22 сентября прошел семинар Научно-учебной лаборатории компании Яндекс.

Докладчик: Егиазарян Ваге, младший научный сотрудник Научно-учебной лаборатории компании Яндекс

Научно-учебная лаборатория компании Яндекс: Стажер-исследователь

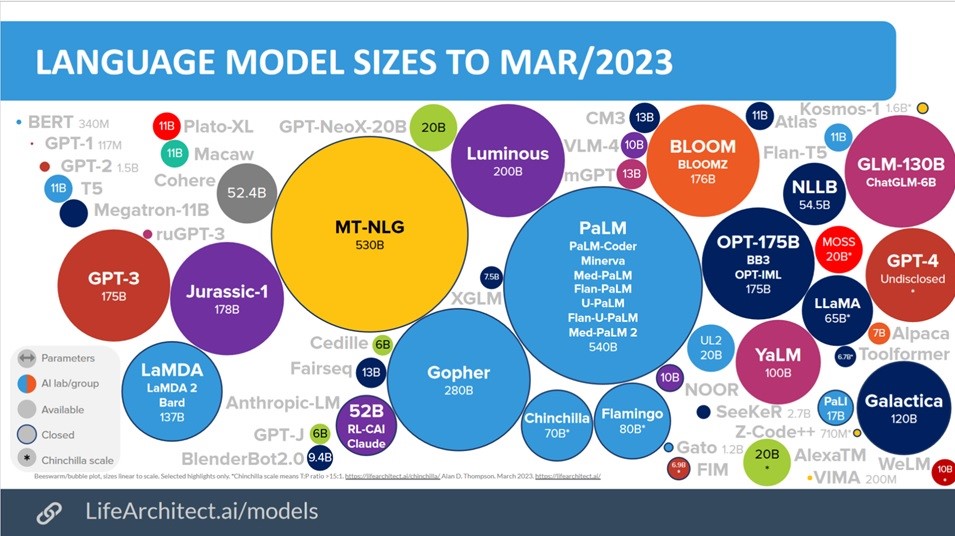

Вместе с быстрым развитием глубокого обучения и растущими размерами языковых моделей, таких как GPT, LLama, OPT и Bloom, возникла необходимость оптимизации и сжатия этих моделей. Сжатие языковых моделей включает различные техники, такие как квантизация, прунинг (удаление ненужных параметров) и дистилляция (передача знаний из большой модели в более компактную). Цель этих техник - уменьшить размер и вычислительную сложность моделей, сохраняя при этом их точность и выразительность. Сжатие языковых моделей открывает новые возможности для их применения в различных областях, включая мобильные устройства, робототехнику, автономные системы и другие, позволяя достичь более быстрой инференции на ресурсно ограниченных устройствах и снизить требования к объему памяти.

На семинаре мы познакомились с одним из направлений сжатия - квантизацией. Основная идея квантизации заключается в замене точных чисел с плавающей запятой на более простые и компактные представления, такие как целочисленные или числа фиксированной точности с меньшей битностью. Мы ознакомились с текущим состоянием дел в этой области и представили последние достижения в данном направлении.

Запись семинара представлена ниже.

Научно-учебная лаборатория компании Яндекс: Менеджер

Егиазарян Ваге Грайрович

Научно-учебная лаборатория компании Яндекс: Стажер-исследователь