Сотрудники факультета представили результаты своих исследований на крупнейшей мировой конференции по машинному обучению NeurIPS

С 2 по 8 декабря 2018 года в Монреале прошла 32-я международная конференция Neural Information Processing Systems (NeurIPS 2018). Ежегодно NeurIPS собирает тысячи исследователей в области машинного обучении, которые представляют свои научные результаты в области глубинного обучения, обучения с подкреплением, масштабируемой оптимизации, байесовских методах и других подразделах машинного обучения. Количество статей, подаваемых на конференцию, каждый год растет, и в этом году составило 4854 (из них 1019 принято).

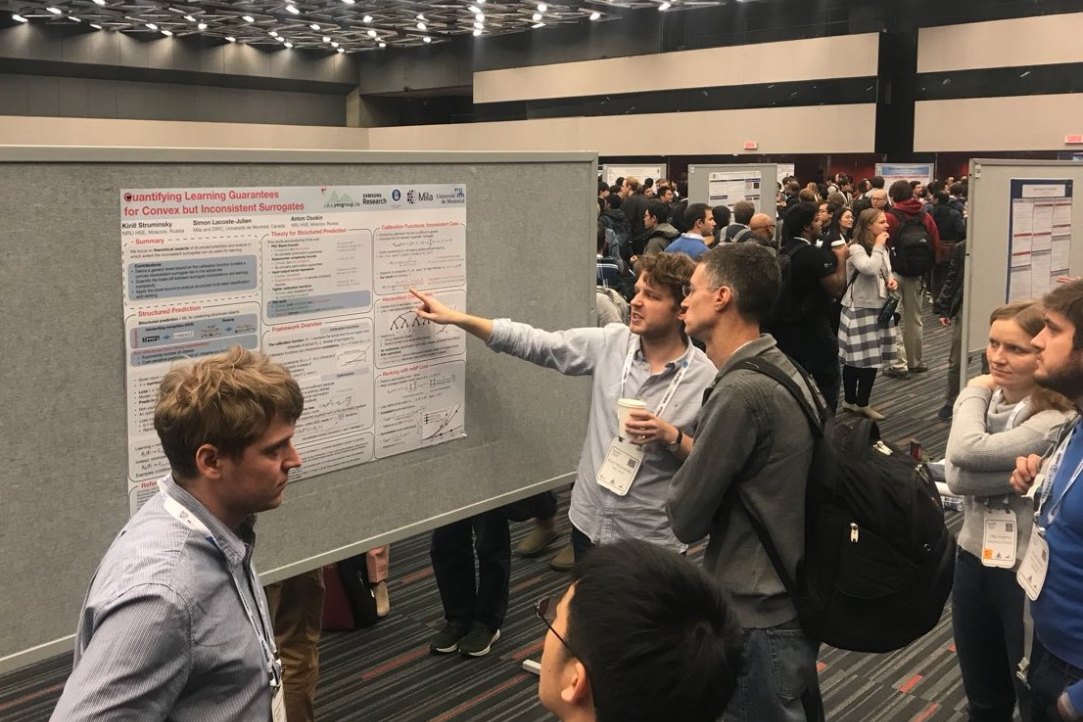

В этом году в основной сетке конференции было представлено три работы сотрудников факультета компьютерных наук: «Loss Surfaces, Mode Connectivity, and Fast Ensembling of DNNs» (короткий устный доклад, авторы: Тимур Гарипов, Павел Измаилов, Дмитрий Подоприхин, Дмитрий Ветров и Эндрю Гордон Уилсон), «Quantifying Learning Guarantees for Convex but Inconsistent Surrogates» (постерный доклад, авторы: Кирилл Струминский, Симон Лакост-Жульен и Антон Осокин), обе — от исследовательской группы байесовских методов, и «Non-metric Similarity Graphs for Maximum Inner Product Search» (постерный доклад, авторы: Станислав Морозов и Артем Бабенко) от Базовой кафедры Яндекс.

Профессор-исследователь ФКН Дмитрий Ветров выступил с приглашенным докладом в дополнительной секции (workshop) Bayesian Deep Learning. В своем докладе он рассказал о полу-неявных вероятностных моделях (semi-implicit modeling) — моделях, позволяющих совместить гибкость неявных вероятностных моделей (таких, как GAN), и простоту обучения явных (например, Normalizing Flows).

Кроме того, в дополнительных секциях были представлены несколько работ исследовательской группы байесовских методов (сотрудники Центра глубинного обучения и байесовских методов, Лаборатории компании Самсунг в НИУ ВШЭ, Центра искусственного интеллекта компании Самсунг в Москве):

- Importance Weighted Hierarchical Variational Inference (авторы: Артем Соболев и Дмитрий Ветров)

- Variational Dropout via Empirical Bayes (авторы: Валерий Харитонов, Дмитрий Молчанов и Дмитрий Ветров)

- Subset-Conditioned Generation Using Variational Autoencoder With A Learnable Tensor-Train Induced Prior (авторы: Максим Кузнецов, Даниил Полыковский и Дмитрий Ветров)

- Joint Belief Tracking and Reward Optimization through Approximate Inference (авторы: Павел Швечиков, Александр Гришин, Арсений Кузнецов, Александр Фрицлер и Дмитрий Ветров)

- Bayesian Sparsification of Gated Recurrent Neural Networks (авторы: Екатерина Лобачева, Надежда Чиркова и Дмитрий Ветров)

.jpg)

Дмитрий Ветров

Профессор-исследователь ФКН

“

В работе “Loss Surfaces, Mode Connectivity, and Fast Ensembling of DNNs” мы выявили и эмпирически исследовали важное свойство нейронных сетей: оказывается, что независимо найденные оптимумы функционала качества соеденены непрерывной кривой, вдоль которой ошибка на тестовой выборке остается приблизительно постоянной. Это открывает возможности для более эффективного ансамблирования нейронных сетей. В настоящий момент мы продолжаем исследования в этом направлении.

Лаборатория компании Самсунг: Младший научный сотрудник