Научный семинар в MTS AI: как улучшаются большие языковые модели

Центр искусственного интеллекта НИУ ВШЭ (далее – Центр ИИ) с MTS AI организуют научные семинары с целью объединения научной экспертизы и практического опыта в области искусственного интеллекта. Участники рассматривают конкретные проблемы и вызовы ИИ. На семинарах обсуждаются вопросы применения инноваций в реальных продуктах партнера. Этот семинар был посвящен большим языковым моделям, которые набирают популярность для решения различных задач.

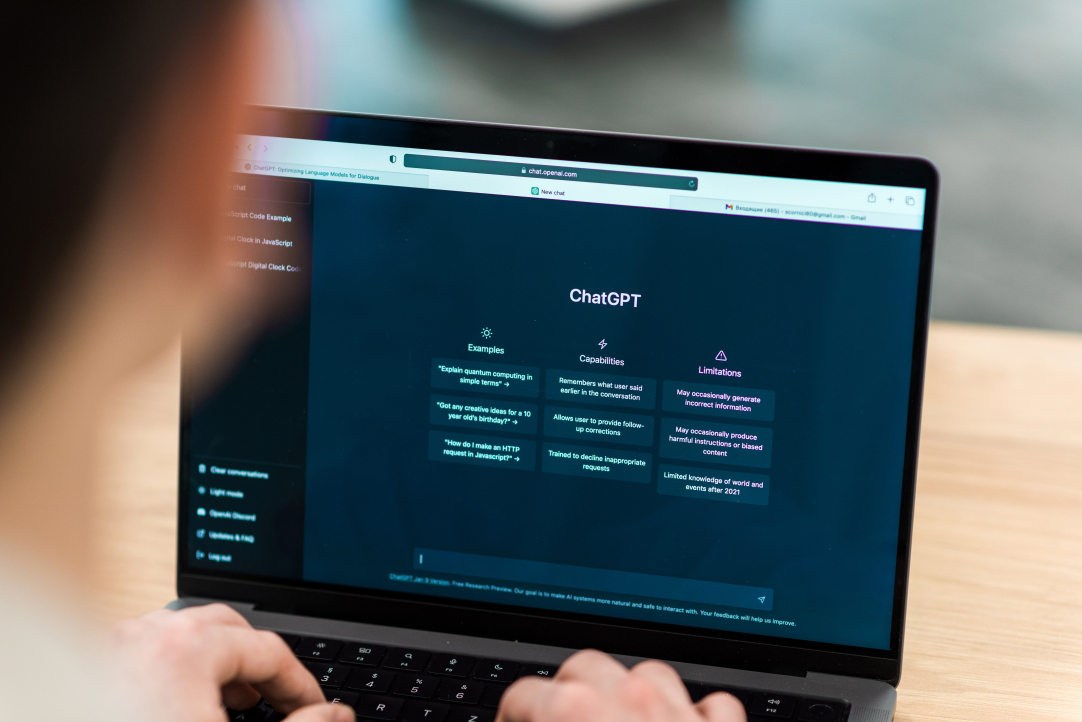

Большие языковые модели (далее БЯМ) – это нейронные сети, обученные на больших объемах данных для автоматической генерации текстов естественного языка. Они способны «понимать» и генерировать текст, обладая широкими знаниями о грамматике, структуре предложений и семантике. Например, с использованием больших языковых моделей работает ChatGPT от компании Open AI, и компания MTS AI тоже создает решения на базе БЯМов.

Елизавета Жемчужина из Центра ИИ представила исследование по оценке эффективности словарей языковых моделей типологией atom-pragma-idea и рассказала о дальнейших шагах по разработке нового метода токенизации данных.

Токенизация (разделение текстов на элементарные единицы, такие как слова, подслова, последовательности слов или символы) в языковых моделях относится к процессу формирования словаря. Размеры и качество наполнения словарей при этом недостаточны для того, чтобы модель могла определить точку «сдвига фазы», когда более длинная последовательность прагм становится идеей и начинает проявлять однозначное соответствие с определенным семантическим концептом. Поэтому большие языковые модели показывают низкую производительность при работе с более длинными последовательностями.

Жемчужина Елизавета Всеволодовна

Лаборатория естественного языка ВШЭ-Яндекс: Стажер-исследователь

В больших текстовых корпусах проявляется закон Ципфа, устанавливающий обратно пропорциональное отношение между частотой появления слова и его рангом. Например, самое часто встречающееся слово будет встречаться приблизительно в два раза чаще, чем второе по частоте слово, в три раза чаще, чем третье по частоте слово, и так далее. В рамках этого закона мы научились выделять семантически и статистически согласованные подгруппы токенов, выработали типологию atom-pragma-idea и оценили наполненность словарей языковых моделей, а также как качество алгоритмов токенизации на конечных задачах соотносится с процентом idea, которое алгоритм добавляет в словарь. В дальнейшем предполагается выработать новый метод токенизации, собирающий словарь языковой модели в соответствии с балансом pragma/idea, что предположительно улучшит качество работы языковых моделей определенными типами последовательностей.

Результаты исследования опубликованы на KnowledgeNLP при AAAI-2023 (Zhemchuzhina et al., "Pragmatic Constraint on Distributional Semantics"). Предложенный метод может быть интегрирован в чат-боты, в том числе тематические с целью снижения затрат на обучение БЯМов. Также результаты исследования могут быть полезны в языковых моделях, где требуется более аккуратный подход к контексту: анализ социальных сетей, системы поддержки клиента, модерация контента и др.

Виктория Чекалина из Сколтеха рассказала про сжатие языковых моделей на основе трансформеров с использованием матричного и тензорного разложения. Предобученные языковые модели на основе трансформеров привлекают большое внимание благодаря их успеху практически во всех задачах обработки естественного языка, устанавливая новые стандарты производительности. Но такие модели имеют серьезное ограничение –необходимость в дорогостоящих графических процессорах с большим объемом оперативной памяти. Предложенные подходы в сочетании с более простыми методами могут минимизировать объем памяти, требуемый для применения БЯМов, и повысить эффективность вычислений.

Подробности представленных исследований можно узнать в записи научного семинара.

Центр ИИ НИУ ВШЭ реализуют проект «Разработка механизмов памяти и внимания для обработки длинных последовательностей» при поддержке индустриального партнера – MTS AI (ООО «Центр ИИ МТС»).